Paradoksalnie większość odbiorców nie ma z tym problemu. Nie trzeba daleko szukać by znaleźć spektakularny przykład, w którym porady z 2012 roku (link) zostały 5 lat później ponownie zalecone w artykule pod tytułem… „Czas przestać robić SEO jak w 2012 roku”. Można wręcz pomyśleć, że to eksperyment sprawdzający tolerancję czytelników na recykling treści.

Publicyści, w swoim pragmatycznym przepisywaniu starych porad na nowo, mają częściową słuszność – clue SEO nie uległo zmianom od lat. Nadal króluje treść oraz linki. Nadal metatag title jest ważny. Nadal indeksowanie jest fundamentem. Zmianom uległy tylko szczegóły, proporcje, metody. Z publicystycznego punktu widzenia to pomijalne drobnostki, jednak w rzeczywistości właśnie te elementy decydują o powodzeniu w wyszukiwarce.

Bezpieczeństwo linkbuildingu

Temat „bezpiecznego linkbuildingu” od kilku lat jest przepisywany na zasadzie: Google zabrania tworzyć sztuczne linki, więc stwórz awesome content i poczekaj aż inni do ciebie zalinkują. Tworzenie dobrej treści jest zawsze świetną strategią, jednak z punktu widzenia pozyskiwania linków – strategią coraz mniej skuteczną. Internauci statystycznie zostawiają coraz mniej linków robotom indeksującym, ponieważ dobre treści są szerowane na Facebooku, portalach linkujących nofollow, a także w zamkniętych grupach i komunikatorach. To właśnie wspomniany szczegół, raczej ignorowany w publicystyce, ale niezmiernie ważny w praktyce, którego ewolucja istotnie wpływa na skuteczność działań.

Innym szczegółem jest zmiana znaczenia ilościowego linków. Każde zestawienie czynników rankingowych, co roku od 6 lat, ze zdziwieniem konkluduje, że linki są nadal istotne. Ich proporcje oraz zastosowania uległy jednak rewolucyjnym zmianom. Pół dekady temu kampanie linkowania składały się z tysięcy linków, natomiast dziś za pomocą kilkunastu precyzyjnych linków jest możliwe skuteczne zamknięcie kilkumiesięcznego procesu. Taką ilość można bardzo dokładnie kontrolować i poprowadzić bezpieczniej nawet niż wspomniane wyżej naturalne linkowanie dobrej treści. Wykorzystujemy do tego m.in. metodę sondy.

Wstęp do eksperymentów SEO z użyciem sond

Eksperymenty SEO, jak każde inne, wymagają pełnego podłoża logicznego (hipoteza, izolacja, grupy itd.) i uważnego wdrożenia. Poruszaliśmy je wielokrotnie na blogu, ostatnio dość dokładnie we wpisie z września 2017. Mogą brać w nich udział zarówno całe domeny jak i poszczególne podstrony, jednak należy zauważyć, że podstrony różnią się pod kątem linkowania wewnętrznego, wieku i wielu innych parametrów, stąd trudno wyizolować możliwie najbardziej obiektywną podstronę. Często nawet porównywanie stron głównych pomiędzy poszczególnymi domenami jest niemiarodajne.

Rozwiązaniem tego problemu jest utworzenie sztucznej, reprezentatywnej podstrony – sondy – dla każdej badanej domeny. Szczegóły wdrożenia powinny być dostosowane do zamiarów eksperymentalnych, jednak muszą być spójne pomiędzy domenami.

Przykładowo, w eksperymencie każda domena może mieć sondę, która składa się z tej samej objętości treści, i do której nie prowadzi żaden link wewnętrzny. Zaindeksowanie sond w wybranych, ściśle monitorowanych wynikach wyszukiwania pozwala na porównywanie sond między sobą. Zastosowania i możliwości są ograniczone w zasadzie tylko założeniami eksperymentu i pewnością statystyczną.

Metoda sondy w bezpiecznym linkbuildingu

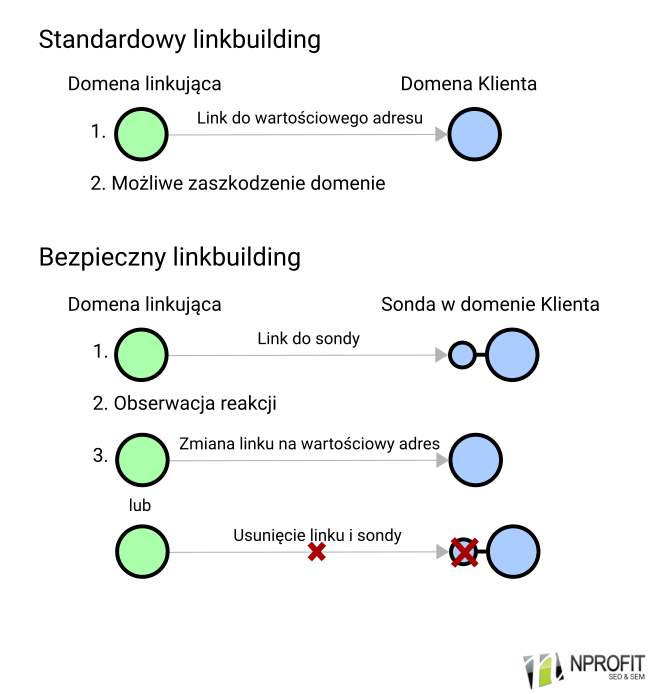

Standardowy linkbuilding sprowadza się do podlinkowania Klienta i obserwacji reakcji. Zazwyczaj jakość linków jest oceniana wcześniej różnymi narzędziami, jednak są one tylko dalekim przybliżeniem faktycznej oceny Google. Dopiero linkowanie daje definitywną odpowiedź, czyli wzrost lub spadek pozycji/widoczności/ruchu/. W przypadku niektórych źródeł linków odpowiedź często może być negatywna – może obniżać pozycje i powodować utratę ruchu z wyszukiwarki.

Metoda sondy wprowadza prewencyjną kontrolę jakości i bezpieczeństwa. Najpierw podlinkowany nie jest Klient, lecz sonda na stronie Klienta. Ewentualny wzrost lub spadek pozycji sondy jest obserwowany w izolowanym środowisku i nie wpływa na ruch z wyszukiwarki. Na podstawie oceny reakcji, można określić czy pozyskanie tego linku w kontekście profilu linków całej domeny, a także charakterystyki danej niszy jest bezpieczne i czy przyniesie pozytywny efekt. Jeśli tak – można bezpośrednio podlinkować docelowy adres Klienta. Jeśli nie – wystarczy usunięcie sondy oraz linku do niej.

Metoda wymaga cierpliwości oraz konsekwentnego wdrażania. W stosunku do standardowego czasu przetwarzania nowego linku przez Google, dochodzi do podwojenia oczekiwania za efekt (wydłużenie średnio z dwóch do czterech tygodni). Jest to jednak znacznie bezpieczniejsze działanie. W standardowym linkbuildingu ewentualne obniżenie pozycji trwa również przynajmniej dwa tygdonie, ponieważ czas przetwarzania odłączonego linku jest analogiczny do czasu przetwarzania nowego linku, a ponadto dotyczy wartościowej strony agregującej ruch. Tymczasem w przypadku niepowodzenia z użyciem metody sondy nie tylko nie wpływamy na adres ważny w wynikach wyszukiwania, ale też jesteśmy w stanie usunąć go, co powoduje wskazywanie linku na błąd 404.

Podobne metody były publikowane w kontekście testowania infrastruktury linkującej, na przykład u Matta Diggity’iego, jednak współczesne algorytmy oceniające jakość linków są specyficzne nie tylko branżowo, ale też biorą pod uwagę charakterystykę linkowanej domeny, a także postać linku. Linkowanie ze strony A do Klienta X może być pozytywne, ale już linkowanie ze strony A do Klienta Y może być negatywne, ponieważ Google ocenia link w kontekście całego, specyficznego profilu. Sonda umieszczona w obrębie domeny docelowej pozwala na pełną kontrolę tego kontekstu.

Jest to oczywiście podstawowy opis procedury, którą w praktyce znacznie rozszerzamy i wieloetapowo modyfikujemy w zależności od zastosowania, źródeł linków, możliwości itd. Bez problemu można (i warto) za jej pośrednictwem kontrolować nie tylko linkbuilding, ale także wdrożenia onsite.

Czy można prowadzić całkowicie bezpieczny linkbuilding?

Żadnych działań w SEO nie można określić całkowicie bezpiecznymi, ponieważ wyszukiwarka zmienia się w czasie. To co dzisiaj, nawet za pomocą dość bezpiecznej metody sondy, jest określone jako pozytywny i bezpieczny link, jutro może stać się przyczyną obniżenia pozycji. Pozycjonowanie jest naprawdę blisko zaprzyjaźnione z Heraklitesowskim panta rhei. Dotyczy to zresztą nie tylko stricte sztucznych działań, ale też naturalnych kampanii, które bywają na celowniku filtrów algorytmicznych i kar ręcznych – praktycznie każda osoba dłużej obecna w branży zna przykłady naturalnych kampanii viralowych czy związanych ze wspieraniem fundacji, które skończyły się pozyskaniem wielu linków i negatywnym wpływem na domenę.

Nie można zapewnić całkowitego bezpieczeństwa, jednak należy pracować za pomocą metod zapewniających możliwie najwyższe bezpieczeństwo. Gdy o sukcesie lub porażce decydują dziesiątki linków, muszą to być dokładnie przetestowane i pewne linki. Ewolucję SEO można górnolotnie porównać do rozwoju medycyny, która w XVIII wieku polegała jeszcze na siermiężnych amputacjach i upuszczaniu krwi, by już pod koniec XIX wieku dojść do precyzyjnych operacji na mózgu. Pole swobody i możliwych błędów uległo diametralnemu zawężeniu, choć jasno trzeba przyznać, że nie stało się to dzięki wybitnym umysłom i postępowi tak jak w medycynie, lecz z powodu coraz ściślejszej presji wywieranej przez Google.

Do słynnego powiedzenia Benjamina Franklina, o tym że na świecie pewne są tylko śmierć i podatki, śmiało można dodać: „i zmiany w wyszukiwarce”. Szczegóły SEO z pewnością zmienią się, ale spowodują to co zawsze: publicyści po raz kolejny przepiszą to co przepisują od lat, a pozycjonerzy po raz kolejny dostosują swoje działania.

Zalinkowane źródła: Webmasters.stackexchange.com, Backlinko.com, Wordstream.com, Moz.com, Diggitymarketing.com.

11 komentarzy

Tomek

Metoda może i jest skuteczna, ale też bardzo czasochłonna i to co zaznaczona bardzo rozłożona w czasie. Wiele czynników niestety często wyklucza też tego typu działania. Temat ciekawy, warto jednak dodać, że w przypadku tego typu linkowania, nad każdym źródłem puszczenia linku do „sondy”, musimy mieć kontrolę. Kontrolę, która pozwoli nam modyfikować link. Koncepcja ciekawa, ale w przypadku sklepu ciężko mi to sobie wyobrazić – chociazby ze względu na problem z umieszczeniem stron „sond” w tak widocznej nawigacji wewnetrznej (i nie tylko).

Natomiast pomysł ciekawy, brawo za wpis 🙂

Adrian Pakulski

Słuszne założenia Rafał, bardzo mi się podoba – co prawda w większości kampanii nie do wdrożenia ze względu na duże koszty operacyjne (a co za tym idzie finansowe z punktu widzenia klienta), ale podstawę ma zasadną. W pewnym zakresie pokrywa się z tym o czym pisałem rok temu http://paq-studio.com/blog/toksyczne-linki-zaplecze-rozwiazuje-ten-problem-kosztownie-ale-jednak/ (link informacyjny, nie robi g*wno szeptanki); co prawda w mojej hipotezie nie monitorujemy w jednoznaczny sposób przełożenia 1 BL do pozycji strony docelowej (czyli nie robimy sondy, wydzielając środowisko testowe), bo w przypadku większych site’ów, jest na to po prostu zbyt mało czasu. Zakładam po prostu, że jeśli zaplecze ma zasięg organiczny np. 10 i wytraci go do zera *, to jest ku temu powód i wtedy można zweryfikować, jak zachowała się strona docelowa, do jakiej linkowała ta zapleczówka. Jeśli jest spadek, to prawdopodobnie wypadkową jest link z tej zapleczówki (bo w moim przypadku linki z zaplecza są najmocniejsze i to ono niejako dźwiga ciężar pozycji, wobec czego bardziej prawdopodobna jest obsuwa przez spaloną zapleczówkę, niż przez dodatkowe 2 linki z zaspamowanego forum). Oczywiście w moim założeniu korelacji 1:1 już takiej nie ma, o jakiej Ty wspominasz, nie mniej zaoszczędzam w ten sposób dużo czasu. Ale szanuję podejście.

* Albo ma 500 i wytraci go do 20; to akurat przykłady analogiczne, bo nie interesuje mnie początkowa widoczność zapleczówki, ale trend i jego tempo tempo ewentualnego spadku – choć i tutaj jest to proces czasochłonny, bo filtr na konkretną frazę nie musi być jednoznaczny z przypisaniem do takiego zaplecza łatki „toksyczności” – no dużo by pisać.

Agnieszka Owczarzak

Zgodzę się z Tomkiem. Pomysł dość ciekawy, ale bardzo czasochłonny, a w niektórych wypadkach wręcz niemożliwy do wykonania (nie zawsze mamy możliwość modyfikowania linku). Trudno będzie też obserwować reakcje, ponieważ na zmiany może wpłynąć dużo więcej czynników niż jeden link.

Marcel

Ciekawy artykuł. Mało kto w branży podaje wyniki testów, a u Was to norma:-)

Który według Was współczynnik domeny jest teraz najbliższy rzeczywistości: Trust Low (Majestic), Domain Rating (Ahrefs) czy Domain Authority (MOZ)?

Pozdrawiam

Rafał Grochala

Na polskim rynku najwięcej linków wykrywa Ahrefs (zazwyczaj), stąd siłą rzeczy ich dane są najpewniejsze. Do tego ostatnia aktualizacja DR ładnie poprawiła używalność tej metryki. Aktualnie Ahrefsowy DR jest przydatny przede wszystkim w górnych zakresach, porównywanie DR>10 jest wartościowe np. przy przechwytywaniu domen, natomiast porównywanie między DR<10 to już bardziej rzut monetą. Jeśli można ukuć jakąś regułę, to na podstawie weryfikacji eksperymentalnej kilkuset przechwyconych domen (od czasu aktualizacji DR) mogę powiedzieć, że wysoki DR zazwyczaj świadczy o mocnej domenie (wyjątek: filtry i kary), natomiast niski DR nie daje zbyt wielu informacji (czasem domeny zaskakująco mocne mają zaskakująco niski DR, a czasem faktycznie są bezwartościowe).

Za które linki dostaje się karę od Google, a które dają 1. miejsce?

[…] (w tym kontekście odsyłam do tekstu https://nprofit.net/pl/2018/bezpieczny-linkbuilding-metoda-sondy/) […]

Marcel_12

Bardzo fajny pomysł, ale w przypadku większości stron chyba się nie sprawdzi. Zajmuje zbyt dużo czasu. Prościej i szybciej jest znaleźć wartościowe strony i tam umieścić bezpośrednio linki niż bawić się z sondą

Mateusz Gwóźdź

Wątpię, aby ktokolwiek realnie budował satelity i badał pojedyncze linki. Nie spotkałem się jeszcze, aby umieszczony link w artykule na popularnej stronie(KB, Di.com, Naszemiasto), wpływał negatywnie. Zamiast tych wszystkich parametrów lepiej sprawdzić widoczność domeny, ruch i historię. Jest obecnie wysyp stron o mega parametrach, a historia wzrostów sięga 2-3 miesięcy, bo ktoś podlinkował przechwyconą domenę na forach :/ Jak Twoim zdaniem wygląda skuteczność oceny toksyczności przez program Clusteric. Badałeś może w ilu przypadkach się sprawdziła ocena programu vs ręczna ocena linków?

Kamil

Masz rację cytując Benjamina Franklina ! Gdyby już wtedy były przeglądarki, na pewno nie pominął by tej kwestii ! 🙂 Pozdrawiam !

Kasia

bezpieczny linkbuilding to organiczny – a nie korzystanie z śmieciowych zapleczy 🙂 wiec czas to podstawa w tym procesie.

Ahrefs - co to za narzędzie i jak go używać? Poradnik - cyber_Folks

[…] Ciekawostka!Link building jest jednym z filarów pozycjonowania. Pozyskiwane odnośniki mają wpływ na pozycje osiągane w wynikach organicznych. Opisane powyżej wskaźniki nie mają bezpośredniego przełożenia na wyniki osiągane w wyszukiwarce. Są to niezależne skale, na podstawie których można wyciągnąć wnioski na temat profilu linkowego domeny. Wskaźniki te mogą różnić się od siebie w zależności od używanego narzędzia. Dodatkowo pierwszy widok pozwala na szybki wgląd w ilość linków zwrotnych, widoczność w wynikach organicznych czy ruch z wyszukiwarki. […]